Post 22: ¿Cuál es la base del éxito de las redes neuronales? 🧐

Published:

Las funciones matemáticas nos permiten modelar el comportamiento de muchas cosas. Todo puede ser descrito en termino de funciones, sin embargo, para hacerlo es necesario saber cuántas variables incluir y cuál es su comportamiento. Es decir, no es fácil crear buenas funciones e implica mucha investigación y creatividad.

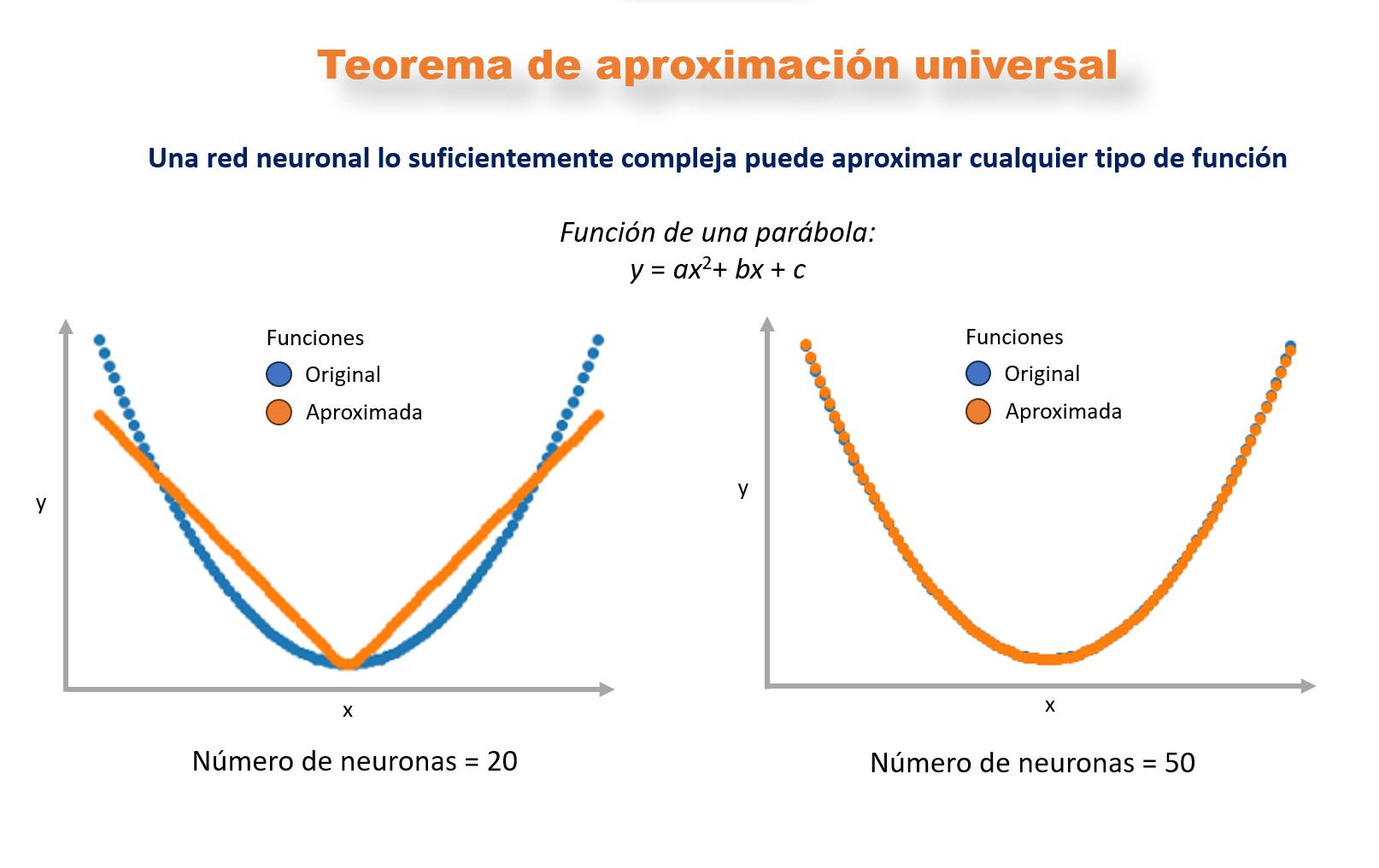

Ahora que tenemos muchos datos, las redes neuronales son muy usadas pues pueden aprender gran variedad de patrones a partir de los datos. Y en esta interacción el “Teorema de aproximación universal”nos asegura que una red neuronal lo suficientemente compleja puede aproximar cualquier tipo de función.

¿Cómo hacemos que una red neuronal sea más compleja? Una forma de hacerlo es aumentando el número de neuronas, lo cual permite aprender patrones más complicados. Por ejemplo, si usamos 20 neuronas para modelar la función de una parábola el resultado no será muy bueno, pero, si aumentamos a 50 neuronas ahora si puede aproximar la parábola de forma muy precisa

La parábola es una función simple, sin embargo, se han usado redes neuronales para aproximar funciones bastante complejas; por ejemplo, para aproximar la ecuación de Schrödinger y modelar moléculas con hasta 30 electrones, cuando en su forma clásica modelar apenas un electrón es bastante complicado. Otro ejemplo es para predecir “eventos canónicos” que acontecen en nuestras vidas: nacer, casarse, morir, etc.; al descomponer la vida como una secuencia de eventos las redes neuronales pueden aprender funciones que de forma muy general “puede predecir nuestro futuro”. Incluso, los sistemas caóticos que son de los más complicados de modelar dado la sensibilidad de sus variables pueden ser modelados hasta cierto punto con redes neuronales.

Ahora, que si todo realmente puede ser descrito por funciones (cosa que es obvio que no). Que tan buenas son estas funciones. Cual es la calidad de los datos de los que aprender las redes neuronales y un sinfín de preguntas más, es debate aparte.

Refs

- Un video muy bonito de Thomas Garrity sobre la importancia de las funciones

- El código para modelar una parábola

Y los artículos donde aproximan …